引言

人脸识别技术,曾被誉为通往未来便捷与安全的金钥匙,如今正以前所未有的速度渗透到社会生活的每一个角落——从手机解锁、移动支付到社区门禁与公共安防。尤其在金融等高风险领域,它被寄予厚望,用以构建“牢不可破”的身份认证防线。然而,当我们越是依赖这张“数字面孔”,其背后潜藏的巨大风险就越是清晰地浮现。本文旨在深入剖析人脸识别技术在三个核心维度上暴露出的致命缺陷:身份验证机制的内在脆弱性、数据采集过程中的隐私侵犯,以及远程集中存储带来的系统性安全风险。我们必须严肃质问:将我们最独特、不可更改的生物特征,托付给一个如此脆弱的系统,是否是一个明智的选择?

第一部分:技术的脆弱性——Deepfake的致命一击

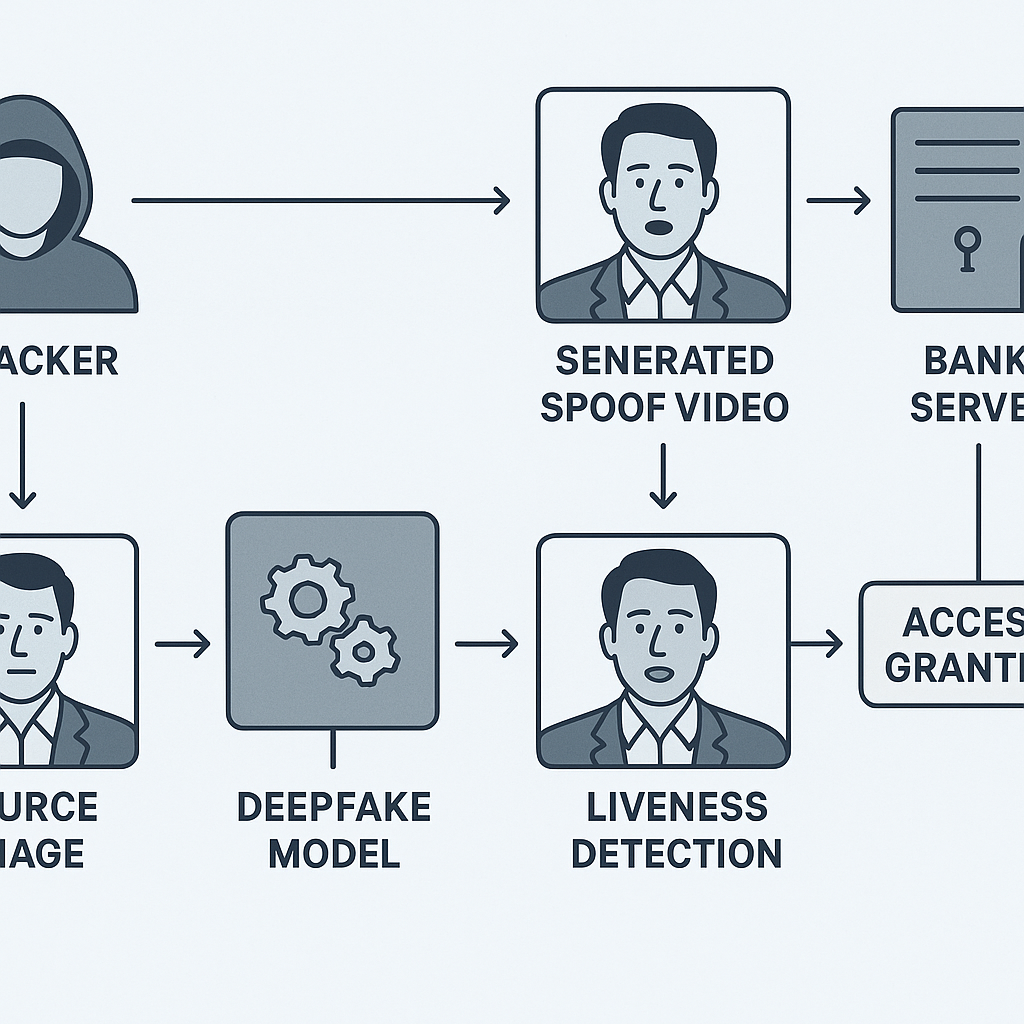

人脸识别作为身份验证手段,其核心逻辑依赖于活体检测(Liveness Detection)与人脸特征比对。然而,以Deepfake(深度伪造)为代表的生成式AI技术,正对这套体系构成降维打击。攻击者不再需要制作物理面具或高仿真照片,而是能以极低的成本生成以假乱真的动态视频,精准绕过防御机制。

攻击原理与路径:

- 绕过活体检测: 传统的活体检测通过要求用户完成眨眼、张嘴、摇头等随机动作来确认其为“真人”。但Deepfake技术可以生成完全模拟这些动作的视频。更具破坏性的是注入攻击(Injection Attacks),攻击者通过虚拟摄像头等工具,直接将伪造的视频流“注入”到认证系统的输入端,完全绕过了物理摄像头前的活体检测环节。数据显示,2023年Deepfake欺诈企图暴涨了惊人的3000%,其中注入攻击数量增加了200%。

- 欺骗人脸比对: 攻击者仅需获取目标一张高清照片,便可通过AI模型生成足以乱真的面部视频,其特征点与原始数据高度吻合,从而顺利通过后端的人脸1:1或1:N比对。

真实世界的警钟:

近期案例显示,印尼一家金融机构在短短时间内遭遇了超过1100起Deepfake欺诈,攻击者利用AI生成的假脸绕过数字KYC流程,成功骗取贷款。更早之前,有犯罪团伙利用网上购买的高清照片制作Deepfake,成功骗取了高达7500万美元的资金。

这些案例雄辩地证明,人脸识别在技术层面远非“安全”,其作为金融级身份认证核心凭证的可靠性已然崩塌。Gartner预测,到2026年,由于Deepfake技术的威胁,30%的企业将对人脸生物识别失去信心。

第二部分:隐私的侵蚀——无处不在的隐蔽采集

与密码或密钥不同,人脸是公开的生物特征,无需我们的主动配合即可被轻易采集。这种特性使其在隐私保护方面存在先天缺陷,而Clearview AI等公司的出现,则将这种风险推向了极致。

无同意的“数字殖民”: Clearview AI公司通过爬取社交网络、新闻网站等公开渠道,秘密建立了一个包含超过300亿张人脸图像的庞大数据库,并向全球执法机构出售其识别服务。这种未经个人明确同意的大规模数据抓取,被批评为对个人隐私的严重侵犯,甚至被称为一种“数字殖民主义”。用户在社交媒体上分享生活点滴时,并未授权自己的面孔被用于构建一个全球性的、可供检索的监控数据库。

对自由的深远影响:

- “被遗忘权”的失效: 在欧盟《通用数据保护条例》(GDPR)框架下,个人拥有“被遗忘权”。然而,一旦面部特征被AI模型学习并整合进其算法参数,即使原始照片被删除,其生物特征信息也可能在分布式模型中“永生”,使得删除请求难以彻底执行。

- 寒蝉效应与社会控制: 当个体知晓自己的行踪、身份、社会关系网络可随时被一张照片所揭示时,言论与行为自由将受到极大压抑,导致强烈的“寒蝉效应”。这为“选择性执法”和“监控资本主义”提供了强大的技术工具,从根本上重构了个人与权力之间的关系。

- 算法偏见与歧视: 研究表明,现有的人脸识别系统对深肤色人群和女性的误识率显著更高。例如,麻省理工学院的研究发现,对深肤色女性的误识率可高达34.7%。在执法等关键场景中,这种技术缺陷可能导致“数字冤案”,加剧社会不公。

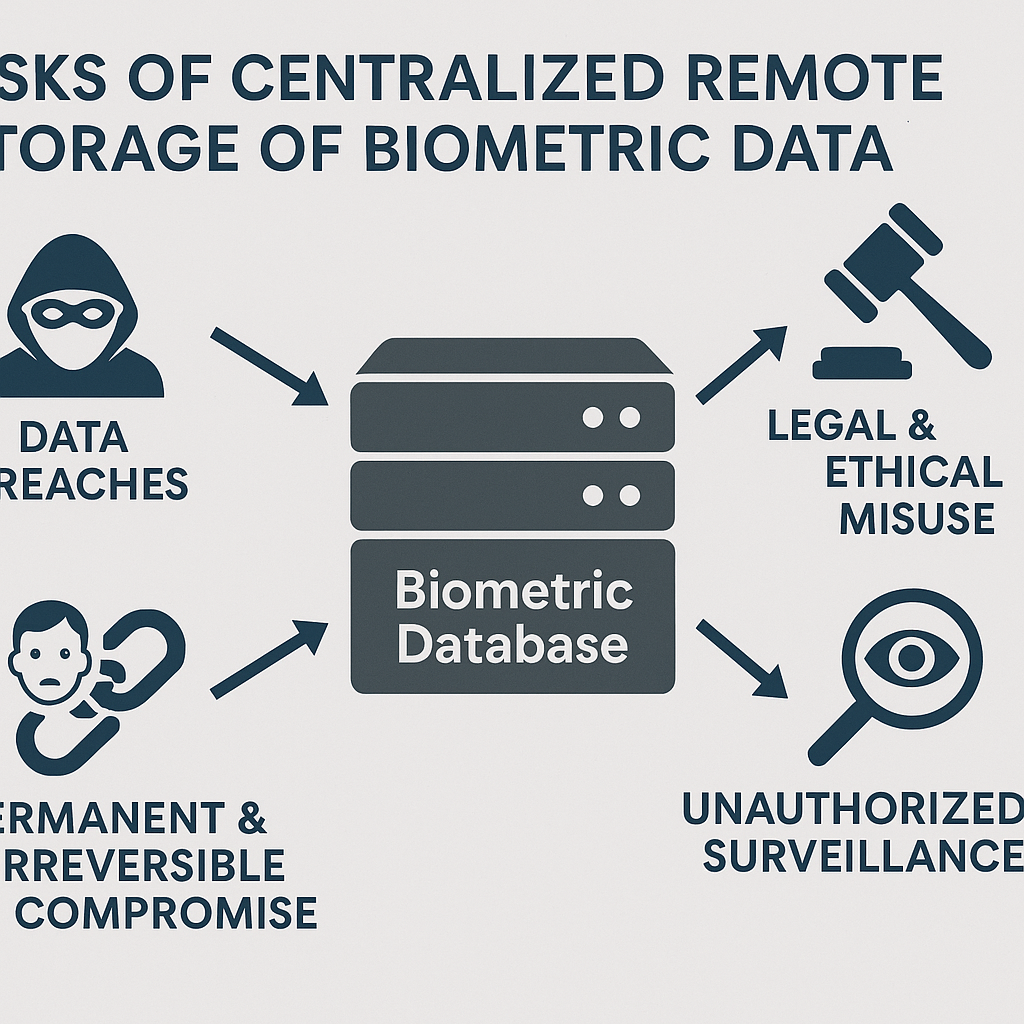

第三部分:数据的达摩克利斯之剑——远程存储的系统性风险

为了实现大规模的人脸比对与识别,我们的面部生物特征数据通常被集中存储在服务提供商的远程服务器上。这种中心化的存储模式,如同悬在我们头顶的一把达摩克利斯之剑,一旦落下,后果不堪设想。

核心风险:不可逆的永久泄露 密码泄露后可以修改,银行卡被盗可以挂失,但人脸是独一无二且终生不变的。一旦存储人脸数据的数据库被攻破,其后果是灾难性且不可逆的。这些数据将永久暴露在暗网和不法分子手中,受害者将终生面临身份被盗用、金融欺诈、精准诈骗乃至人身安全的威胁。

历史的教训:

- 印度Aadhaar数据库泄露 (2018年): 堪称史上最大规模的生物信息泄露事件,波及超过11亿印度公民,泄露内容包括照片、指纹和虹膜扫描等敏感生物数据。

- 中国“深网视界”数据泄露 (2019年): 一家为警方提供服务的人脸识别公司数据库因未设密码而完全暴露,超过250万人的详细个人信息及面部数据可被公开访问。

- 美国人事管理局(OPM)泄露 (2015年): 超过560万联邦雇员的指纹及其他生物特征数据被盗,对国家安全构成直接威胁。

这些事件反复警示我们,没有任何系统是绝对安全的。将数以亿计的、不可更改的生物特征数据集中存放,无异于制造了一个极具吸引力且极度危险的攻击目标。

第四部分:法律与伦理的反思

面对人脸识别技术带来的系统性风险,全球范围内的法律与伦理讨论正日益激烈。

法律框架的应对与不足:

- 欧盟《通用数据保护条例》(GDPR) 和 美国《伊利诺伊州生物特征信息隐私法》(BIPA) 是两大标杆性法规。它们共同确立了处理生物特征数据的核心原则:获取用户明确的、知情的书面同意。GDPR将生物数据列为“特殊类别数据”,原则上禁止处理;BIPA则赋予了个人直接起诉违法企业的权利,并已促成多起数亿美元的和解案。

- 在中国,《民法典》和《个人信息保护法》已将生物识别信息纳入个人信息的保护范畴,并明确其敏感地位。国内“人脸识别第一案”的判决,也彰显了司法对个人权利的保护。

然而,法律的脚步往往滞后于技术的发展。面对Clearview AI这类跨境运营的公司,单一国家的监管机构时常感到力不从心。此外,如何界定“公共利益”的豁免范围,防止其被滥用为大规模监控的借口,仍是全球立法者面临的巨大挑战。

伦理困境: 人脸识别的应用触及了深刻的伦理困境。我们是否愿意为了效率和便利,让渡我们最基本的隐私权和匿名权?当技术被用于扫描阵亡士兵以识别身份(如Clearview AI在乌克兰的行为),这是否跨越了基本的人道主义底线?这些问题没有简单的答案,但它们迫使我们思考技术发展的终极目的——是服务于人,还是控制人?

结论:呼唤刹车与转向

综合以上分析,人脸识别技术在当前阶段存在着不可忽视的“三重门”困境:技术上的脆弱性使其易被Deepfake等手段攻破,无法承担高安全场景的重任;采集上的公开性使其极易在用户不知情的情况下被滥用,严重侵蚀个人隐私与自由;存储上的中心化则使其成为极具吸引力的攻击目标,数据泄露将造成不可逆的终身伤害。

因此,我们必须对人脸识别技术的无序扩张踩下“刹车”。特别是在金融、教育、雇佣等关键领域,应严格限制其应用,甚至在更完善的解决方案出现前予以暂停。未来的身份验证技术,应当向去中心化、用户自主控制、多因素结合的方向发展,例如基于硬件安全模块(HSM)的私钥体系、零知识证明(Zero-Knowledge Proofs)等,确保用户的生物特征数据永远不必离开个人设备。

技术本身是中立的,但技术的应用必须被置于审慎的伦理与法律框架之下。对人脸识别的深刻反思与检讨,不仅是对个人权利的捍卫,更是为了确保我们在迈向数字化未来的道路上,不会迷失人性的方向。

参考文献

- Group-IB & Global Security Magazine. (2024). Deepfake Fraud: How AI is Bypassing Biometric Security in Financial Institutions.

- Gartner, Inc. (2023). Predicts 2024: Identity and Access Management.

- Forbes & European Data Protection Authorities. (2024). Reports on Clearview AI fines and legal challenges.

- ACLU. (Ongoing). Litigation against Clearview AI regarding violations of BIPA.

- WIRED & BBC News. (2019-2021). Reports on major biometric data breaches, including Aadhaar and SenseNets.

- Thales Group & Liminal.co. (2023). Analysis of Biometric Data Protection Laws (GDPR, BIPA).

- Sectigo & TerraNova Security. (2023). Research on Multi-Factor Authentication (MFA) weaknesses and biometric vulnerabilities.

- Zhihu & Secrss.com. (2023). Technical analysis of Deepfake attacks on financial risk control systems in China.

- MIT Media Lab. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification.